ในช่วงไม่กี่เดือนที่ผ่านมา ชุมชน AI ต้องเผชิญกับการถกเถียงอย่างดุเดือด ซึ่งจุดชนวนมาจากงานวิจัยสำคัญสองชิ้นที่ Apple ตีพิมพ์ บทความแรกชื่อ "GSM-Symbolic" (ตุลาคม 2024) และบทความที่สองชื่อ "The Illusion of Thinking" (มิถุนายน 2025) ได้ตั้งคำถามถึงความสามารถในการใช้เหตุผลของ Large Language Models ซึ่งก่อให้เกิดปฏิกิริยาที่หลากหลายจากหลากหลายสาขา

ดังที่เราได้กล่าวไว้ในบทความก่อนหน้านี้ เรื่อง "ภาพลวงตาแห่งความก้าวหน้า: การจำลองปัญญาประดิษฐ์ทั่วไปโดยไม่บรรลุเป้าหมาย" ประเด็นเรื่องการใช้เหตุผลเชิงประดิษฐ์นั้นเป็นหัวใจสำคัญของสิ่งที่เราพิจารณาว่าเป็นสติปัญญาในเครื่องจักร

นักวิจัยของ Apple ได้ทำการวิเคราะห์แบบจำลอง การใช้เหตุผลขนาดใหญ่ (LRM) อย่างเป็นระบบ ซึ่งเป็นแบบจำลองที่สร้างเส้นทางการใช้เหตุผลโดยละเอียดก่อนที่จะให้คำตอบ ผลลัพธ์ที่ได้นั้นน่าประหลาดใจ และสำหรับหลายๆ คนแล้ว ถือเป็นเรื่องน่าตกใจ

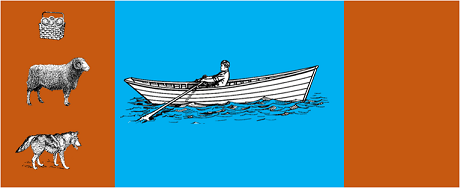

การศึกษาได้นำแบบจำลองขั้นสูงมาใช้กับปริศนาอัลกอริทึมคลาสสิก เช่น:

ผลการศึกษาแสดงให้เห็นว่าการเปลี่ยนแปลงเพียงเล็กน้อยในการกำหนดสูตรปัญหาก็นำไปสู่ การเปลี่ยนแปลงประสิทธิภาพอย่างมีนัยสำคัญ ซึ่งชี้ให้เห็นถึงจุดอ่อนที่น่ากังวลใน เหตุผล รายงานของ AppleInsider ระบุว่า "ประสิทธิภาพของโมเดลทั้งหมดลดลงเมื่อมีการเปลี่ยนแปลงเฉพาะค่าตัวเลขในคำถามเปรียบเทียบมาตรฐาน GSM-Symbolic"

การตอบสนองของชุมชน AI นั้นรวดเร็วมาก อเล็กซ์ ลอว์เซน จาก Open Philanthropy ร่วมมือกับคล็อด โอปุส จาก Anthropic เผยแพร่คำตอบโดยละเอียดในหัวข้อ "ภาพลวงตาของภาพลวงตาแห่งการคิด" ซึ่งท้าทายวิธีการและข้อสรุปจากการศึกษาของ Apple

เมื่อลอว์เซนทำการทดสอบซ้ำโดยใช้วิธีการอื่น เช่น ให้โมเดลสร้างฟังก์ชันแบบเรียกซ้ำแทนที่จะแสดงรายการการเคลื่อนไหวทั้งหมด ผลลัพธ์ที่ได้กลับแตกต่างไปอย่างมาก โมเดลอย่าง Claude, Gemini และ GPT สามารถแก้ปัญหา Tower of Hanoi ได้ด้วยดิสก์ 15 แผ่น ซึ่งมีความซับซ้อนเกินกว่าที่ Apple รายงานว่าไม่มีความสำเร็จเลย

แกรี่ มาร์คัส นักวิจารณ์ความสามารถในการใช้เหตุผลของหลักสูตรนิติศาสตร์ (LLM) มาอย่างยาวนาน ยกย่องผลการวิจัยของแอปเปิลว่าเป็นการยืนยันวิทยานิพนธ์ของเขาเมื่อ 20 ปีก่อน มาร์คัสกล่าวว่า หลักสูตรนิติศาสตร์ (LLM) ยังคงประสบปัญหากับ "การเปลี่ยนแปลงการกระจาย" ซึ่งเป็นความสามารถในการสรุปผลนอกเหนือจาก ข้อมูล ที่ใช้ฝึกฝน ในขณะที่ยังคง "เป็นนักแก้ปัญหาที่แก้ได้เก่ง"

การอภิปรายยังขยายไปสู่ชุมชนเฉพาะทาง เช่น LocalLlama บน Reddit ซึ่งนักพัฒนาและนักวิจัยถกเถียงกันถึงผล ในทางปฏิบัติ ของโมเดลโอเพ่นซอร์สและการใช้งานในระดับท้องถิ่น

การถกเถียงนี้ไม่ใช่เพียงเรื่องวิชาการเท่านั้น แต่มันมีความหมายโดยตรงต่อ:

ตามที่เน้นไว้ใน ข้อมูลเชิงเทคนิค หลายฉบับ ความจำเป็นในการใช้แนวทางแบบผสมผสานที่ผสมผสาน:

ตัวอย่างง่ายๆ : ผู้ช่วย AI ที่ช่วยเรื่องบัญชี โมเดลภาษาเข้าใจเมื่อคุณถามว่า "เดือนนี้ฉันใช้จ่ายไปกับการเดินทางเท่าไหร่" และดึงพารามิเตอร์ที่เกี่ยวข้องออกมา (หมวดหมู่: การเดินทาง, ช่วงเวลา: เดือนนี้) แต่คำสั่ง SQL ที่สืบค้นฐานข้อมูล คำนวณผลรวม และตรวจสอบข้อจำกัดทางภาษีล่ะ? คำสั่งนี้ทำโดยโค้ดแบบกำหนดได้ ไม่ใช่แบบจำลองทางประสาท

ผู้สังเกตการณ์ต่างจับตามองอย่างใกล้ชิดว่าเอกสารของ Apple เผยแพร่ก่อน WWDC ไม่นานนัก ทำให้เกิดคำถามเกี่ยวกับแรงจูงใจเชิงกลยุทธ์ ดังที่ บทวิเคราะห์ของ 9to5Mac ระบุว่า "ช่วงเวลาของเอกสาร Apple ก่อน WWDC เล็กน้อย ทำให้หลายคนตั้งคำถามว่า นี่เป็นก้าวสำคัญด้านการวิจัย หรือเป็นการเคลื่อนไหวเชิงกลยุทธ์เพื่อปรับตำแหน่งของ Apple ในวงการ AI โดยรวมกันแน่"

การถกเถียงที่เกิดขึ้นจากเอกสารของ Apple เตือนเราว่าเรายังอยู่ในช่วงเริ่มต้นของการทำความเข้าใจปัญญาประดิษฐ์ ดังที่ได้เน้นย้ำไว้ใน บทความก่อนหน้า ของเรา ความแตกต่างระหว่างการจำลองสถานการณ์และการใช้เหตุผลที่แท้จริงยังคงเป็นหนึ่งในความท้าทายที่ซับซ้อนที่สุดในยุคสมัยของเรา

บทเรียนที่แท้จริงไม่ได้อยู่ที่ว่า LLM สามารถ "ใช้เหตุผล" ในความหมายของมนุษย์ได้หรือไม่ หากแต่อยู่ที่ว่าเราจะสร้างระบบที่ใช้ประโยชน์จากจุดแข็งของพวกเขา พร้อมกับชดเชยข้อจำกัดเหล่านั้นได้อย่างไร ในโลกที่ AI กำลังเปลี่ยนแปลงอุตสาหกรรมทั้งหมด คำถามไม่ได้อยู่ที่ว่าเครื่องมือเหล่านี้ "ชาญฉลาด" หรือไม่ แต่เป็นคำถามที่ว่า เราจะใช้มันอย่างมีประสิทธิภาพและมีความรับผิดชอบได้อย่างไร

อนาคตของ AI ระดับองค์กรอาจไม่ได้ขึ้นอยู่กับแนวทางการปฏิวัติเพียงแนวทางเดียว แต่อยู่ที่การผสมผสานเทคโนโลยีเสริมต่างๆ เข้าด้วยกันอย่างชาญฉลาด และในสถานการณ์เช่นนี้ ความสามารถในการประเมินความสามารถของเครื่องมือต่างๆ ของเราอย่างมีวิจารณญาณและตรงไปตรงมาจะกลายเป็นข้อได้เปรียบในการแข่งขันในตัวมันเอง

ความคืบหน้าล่าสุด (มกราคม 2569)

OpenAI เปิดตัว o3 และ o4-mini : เมื่อวันที่ 16 เมษายน 2568 OpenAI ได้เปิดตัว o3 และ o4-mini ซึ่งเป็นโมเดลการให้เหตุผลที่ล้ำหน้าที่สุดในซีรี่ส์ o อย่างเป็นทางการ โมเดลเหล่านี้สามารถใช้เครื่องมือในลักษณะแบบเอเจนต์ได้แล้ว โดยผสมผสานการค้นหาเว็บ การวิเคราะห์ไฟล์ การให้เหตุผลเชิงภาพ และการสร้างภาพ o3 ได้สร้างสถิติใหม่ในเกณฑ์มาตรฐานต่างๆ เช่น Codeforces, SWE-bench และ MMMU ในขณะที่ o4-mini ปรับปรุงประสิทธิภาพและต้นทุนสำหรับงานการให้เหตุผลปริมาณมาก โมเดลเหล่านี้แสดงให้เห็นถึงความสามารถในการ "คิดเชิงภาพ" โดยการแปลงเนื้อหาเป็นภาพเพื่อการวิเคราะห์ที่ลึกซึ้งยิ่งขึ้น

DeepSeek-R1 พลิกโฉมวงการ AI : ในเดือนมกราคม 2025 DeepSeek ได้เปิดตัว R1 โมเดลการให้เหตุผลแบบโอเพนซอร์ส ซึ่งมีประสิทธิภาพเทียบเท่ากับ OpenAI O1 ด้วยต้นทุนการฝึกฝนเพียง 6 ล้านดอลลาร์ (เทียบกับหลายร้อยล้านดอลลาร์สำหรับโมเดลจากฝั่งตะวันตก) DeepSeek-R1 แสดงให้เห็นว่าทักษะการให้เหตุผลสามารถเพิ่มขึ้นได้ด้วยการเรียนรู้แบบเสริมแรงล้วนๆ โดยไม่จำเป็นต้องมีหลักฐานพิสูจน์จากมนุษย์ โมเดลนี้กลายเป็นแอปฟรีอันดับ 1 บน App Store และ Google Play ในหลายสิบประเทศ ในเดือนมกราคม 2026 DeepSeek ได้เผยแพร่เอกสารฉบับขยาย 60 หน้าที่เปิดเผยความลับของการฝึกฝนและยอมรับอย่างตรงไปตรงมาว่าเทคนิคต่างๆ เช่น Monte Carlo Tree Search (MCTS) ไม่ได้ผลสำหรับการให้เหตุผลทั่วไป

บริษัท Anthropic ปรับปรุง "รัฐธรรมนูญ" ของ Claude : เมื่อวันที่ 22 มกราคม 2026 บริษัท Anthropic ได้เผยแพร่รัฐธรรมนูญฉบับใหม่สำหรับ Claude ซึ่งมีความยาว 23,000 คำ โดยเปลี่ยนจากแนวทางที่ยึดกฎเกณฑ์มาเป็นแนวทางที่ยึดหลักความเข้าใจในหลักการทางจริยธรรม เอกสารฉบับนี้ถือเป็นกรอบการทำงานฉบับแรกจากบริษัท AI ขนาดใหญ่ที่ยอมรับอย่างเป็นทางการถึงความเป็นไปได้ของจิตสำนึกหรือสถานะทางศีลธรรมของ AI โดยระบุว่า Anthropic ห่วงใย "สุขภาวะทางจิตใจ ความรู้สึกถึงตัวตน และความเป็นอยู่ที่ดี" ของ Claude

การถกเถียงทวีความรุนแรงขึ้น : การศึกษาในเดือนกรกฎาคม 2025 ได้จำลองและปรับปรุงเกณฑ์มาตรฐานของ Apple โดยยืนยันว่า LRM ยังคงมีข้อจำกัดด้านการรับรู้เมื่อความซับซ้อนเพิ่มขึ้นในระดับปานกลาง (ประมาณ 8 ดิสก์ในหอคอยฮานอย) นักวิจัยแสดงให้เห็นว่านี่ไม่ได้เป็นเพียงเพราะข้อจำกัดด้านผลลัพธ์เท่านั้น แต่ยังเป็นเพราะข้อจำกัดด้านการรับรู้ในโลกแห่งความเป็นจริงด้วย ซึ่งเน้นย้ำว่าการถกเถียงยังไม่จบลง

หากต้องการข้อมูลเชิงลึกเกี่ยวกับกลยุทธ์ AI ขององค์กรของคุณและการนำโซลูชันที่แข็งแกร่งมาใช้ ทีมผู้เชี่ยวชาญของเรายินดีให้คำปรึกษาแบบเฉพาะบุคคล